La création de Wikipédia a été un des événements importants dans le développement de l'internet 2.0. L'encyclopédie est aujourd'hui un des sites les plus visités au monde. Elle offre une contenu extrêmement large et riche, qui a conduit à la disparition (

Quid,

Encarta) ou à la marginalisation (

Encyclopedia Universalis) de ses principaux concurrents. Sa fin est pourtant proche : du moins la fin du modèle par lequel elle s'est développée.

La principale spécificité de Wikipédia tient dans le fait qu'elle soit "librement éditable par tous" : elle est l'œuvre de centaine de milliers de contributeurs, anonymes et "amateurs" pour la plupart. Elle a ainsi redéfini les frontières de la légitimité intellectuelle, fondée antérieurement sur le modèle de l'auteur aux compétences universitaires reconnues, dont la signature certifie et authentifie la contribution.

Mais de cette spécificité découle sa principale limite existentielle : elle n'existe, et ne s'améliore, que pour autant que des contributeurs y participent. Son succès n'est pas détachable du processus social complexe par lequel des centaines de milliers de personnes ont accepté de créer de nouveaux contenus, alors qu'elles n'en tiraient aucune rétribution financière et en obtenaient une reconnaissance sociale nulle ou presque nulle, puisque leur travail est anonyme.

C'est ce processus social qui est arrivé à terme. Ce phénomène est parfois entrevu dans les pages communautaires de l'encyclopédie, notamment de sa version française. Il est généralement attribué aux conflits sociaux qui peuvent exister au sein de l'encyclopédie, provoquant le départ de certains contributeurs. Cette vision est, en fait, sociologiquement naïve, en ce qu'elle oublie la limite "écologique" sur laquelle s'est construite Wikipédia -limite qui était présente à l'état latent dès son commencement, avant même qu'elle ne soit atteinte.

Prenons le cas de la version en langue française de l'encyclopédie. Aussi vaste que soit le nombre de ses contributeurs potentiels, il n'est pas infini : parmi les 80 millions de francophones vivant dans un pays disposant d'un réseaux internet développé, il n'en existe nécessairement qu'un nombre précis, limité, prêts à ajouter du contenu dans les conditions très particulières (gratuité, anonymat) qui caractérisent Wikipédia (

première limite) et disposant de compétences telles qu'ils puissent le faire (

deuxième limite). Ce nombre atteint, la population de contributeurs cessera d'augmenter, ou elle ne le fera plus que selon le rythme très lent, presque imperceptible, des transformations démographiques de la population francophone (arrivée de nouvelles générations).

En première analyse, la croissance du nombre de contributeur répond donc grossièrement aux trois logiques suivantes :

1. Plus de contributeurs créent plus de contenu, et de meilleure qualité -ce qui améliore le trafic sur le site et attire donc plus de contributeurs potentiels vers celui-ci. Ces contributeurs vont à leur tour créer plus de contenu, ce qui attirera plus de contributeurs potentiels, etc.

2. Toutefois, à chaque fois qu'un contributeurs potentiel devient un contributeur actif le nombre de contributeurs potentiels total diminue -jusqu'à la limite fixée par le nombre total de contributeurs potentiels, acceptant les conditions spécifiques que fixe Wikipédia (anonymat, gratuité) (première limite).

3. Qui plus est, à chaque fois qu'un nouveau contributeur ajoute du contenu nouveau, le niveaux de compétence requis augmente et les contenus potentiellement ajoutables diminuent, ce qui limite la possibilité pour de nouveaux utilisateurs de contribuer. Au commencement du site, aucune connaissance, même la plus élémentaire, n'était présente : cela rendait possible la participation d'un très grand nombre d'utilisateurs. Au fur et à mesure que le contenu est complété, il n'existe qu'un nombre de plus en plus restreint d'utilisateurs disposant des compétences nécessaires pour encore participer. C'est le deuxième mécanisme qui explique la présence d'un plafond au nombre potentiel de contributeurs, à côté du nombre nécessairement limité de personne désireuses de partager leur savoir dans les conditions spécifiques que fixe Wikipédia.

Le premier mécanisme est caractéristique des croissances exponentielles. Les deux autres mécanismes freinent au contraire cette croissance, de plus en plus fortement au fur et à mesure que le nombre de contributeurs grandit jusqu'à atteindre la population maximale. Ensemble, ils forment une courbe de croissance dite logistique, qui les combine mathématiquement.

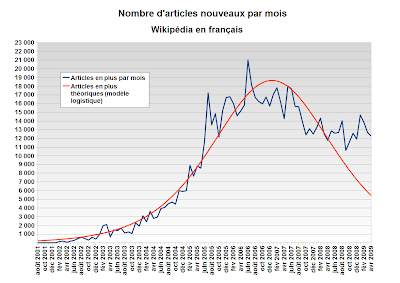

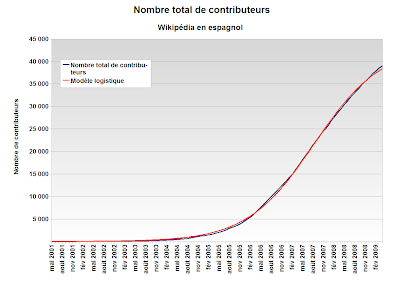

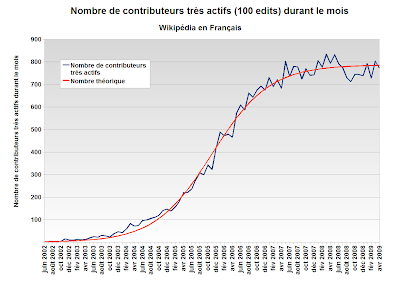

Depuis son commencement, la croissance du nombre total de personnes ayant participé à Wikipédia à travers un compte enregistré 1 a suivi très étroitement ce modèle théorique 2:

Le nombre de contributeur a rapidement augmenté, à un rythme exponentiel, puis après un point d'inflexion, sa croissance s'est ralentie, à mesure qu'il s'approche de son maximum. On voit que, à suivre le modèle théorique, le nombre total de personnes ayant participé à Wikipédia va atteindre ce maximum d'ici deux ans, avec approximativement 50 000 personnes ayant participé. La croissance du nombre de nouveaux participants dans le modèle théorique a, néanmoins, tendance à décroitre plus vite que dans la réalité : on peut donc penser que le processus prendra plus de temps pour arriver à son terme.

Le nombre de contributeur a rapidement augmenté, à un rythme exponentiel, puis après un point d'inflexion, sa croissance s'est ralentie, à mesure qu'il s'approche de son maximum. On voit que, à suivre le modèle théorique, le nombre total de personnes ayant participé à Wikipédia va atteindre ce maximum d'ici deux ans, avec approximativement 50 000 personnes ayant participé. La croissance du nombre de nouveaux participants dans le modèle théorique a, néanmoins, tendance à décroitre plus vite que dans la réalité : on peut donc penser que le processus prendra plus de temps pour arriver à son terme.

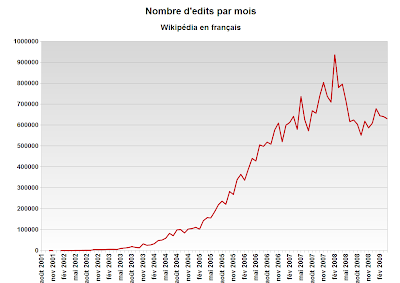

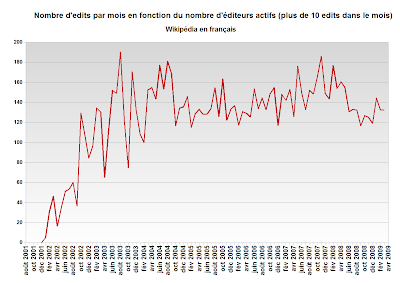

Pour mieux comprendre ce phénomène, on peut s'intéresser au rythme par lequel de nouveaux contributeurs sont arrivés sur Wikipédia depuis sa création :

La croissance du nombre de wikipédiens a accéléré très rapidement après la naissance de l'encyclopédie en français, pour atteindre son maximum à la mi 2007, un peu plus de 5 ans après sa création (moment de la croissance exponentielle, conforme au premier mécanisme). Depuis, le nombre de nouveaux wikipédiens par mois ne cesse de diminuer, même s'il le fait un peu moins vite que selon le modèle théorique (freinage dû aux deux autres mécanismes). Dans l'ensemble, cette croissance s'est faite conformément au modèle logistique, à l'exception de la fin de l'année 2005, marquée par un très fort afflux de nouveaux participants.

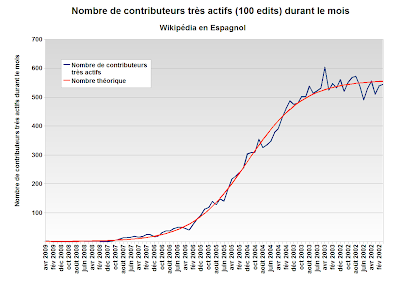

Le développement du nombre de wikipédiens sur l'encyclopédie en français n'a rien d'exceptionnel et se retrouve sur les autres versions linguistiques de l'encyclopédie. Il en va ainsi pour la deuxième plus grande version linguistique de l'encyclopédie, après l'anglaise : Wikipédia en allemand.

Cette similitude des processus souligne assez qu'ils répondent tous deux à la même logique, que stylise exceptionnellement bien le modèle logistique. C'est donc dans ce modèle de croissance de population qu'il faut chercher l'évolution du nombre de participants, et non dans l'analyse des conflits agitant la communauté des wikipédiens.

Toutefois, ce modèle n'explique pas un fait, qu'il met néanmoins en valeur : le nombre relatif de contributeurs à la version allemande a, dès le départ, été nettement supérieur à celui de la version française. Aux termes d'une évolution structurellement identique, sa population asymptotique l'est de 60% -proportion bien plus élevée que celle du rapport de germanophones disposant d'une connexion internet par rapport aux francophones. On peut y voir l'effet du rejet culturel bien plus fort dont a fait l'objet Wikipédia en France, comparé à l'Allemagne, en particulier au sein de ses élites intellectuelles. Nul Pierre Assouline de l'autre coté du Rhin, mais un financement public de son fonctionnement. C'est cela qui a limité le développement de Wikipédia en français. Mais il en était ainsi dès le principe.

La suite est à lire ici.

________________________________________

1. C'est à dire de personnes qui ont créé un compte utilisateur, plutôt que d'utiliser l'"IP" de leur connexion internet, et qui ont au moins édité 10 fois Wikipédia. Les données sont disponibles ici. Ce post doit beaucoup à l'analyse de la croissance du nombre d'articles de Wikipédia en anglais disponible ici.

2. L'équation estimée ici est celle d'un modèle logistique standard : f(t) = population maximale/(1+a*exp(-r*t)), avec t le nombre de mois depuis la création de Wikipédia en français.

Lire la suite

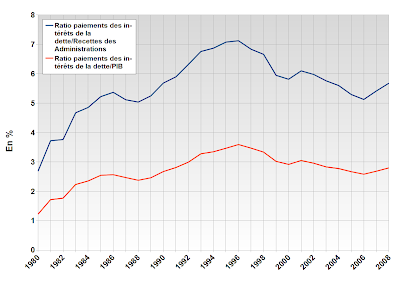

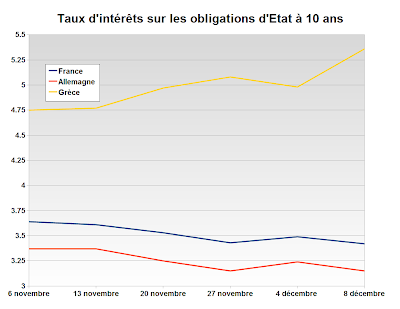

Les taux d'intérêt sur les obligations de l'Etat grec sont donc négativement corrélés avec ceux de la dette de l'Etat français.

Les taux d'intérêt sur les obligations de l'Etat grec sont donc négativement corrélés avec ceux de la dette de l'Etat français.